目录

目录Python全系列 教程

3567个小节阅读:5930.3k

目录

鸿蒙应用开发

C语言快速入门

JAVA全系列 教程

面向对象的程序设计语言

Python全系列 教程

Python3.x版本,未来主流的版本

人工智能 教程

顺势而为,AI创新未来

大厂算法 教程

算法,程序员自我提升必经之路

C++ 教程

一门通用计算机编程语言

微服务 教程

目前业界流行的框架组合

web前端全系列 教程

通向WEB技术世界的钥匙

大数据全系列 教程

站在云端操控万千数据

AIGC全能工具班

A A

White Night

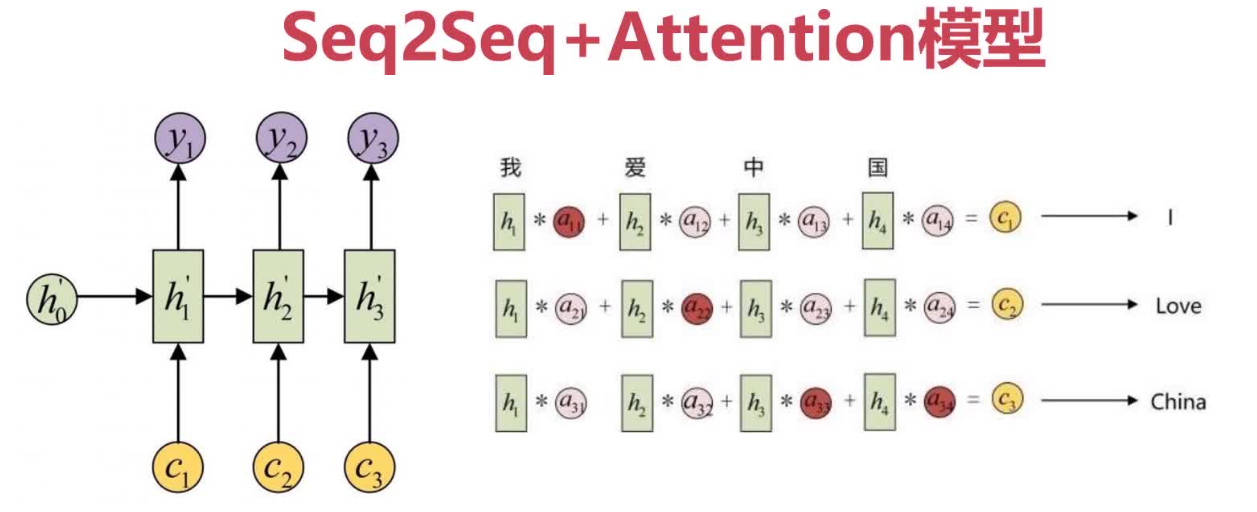

Seq2Seq作为一种通用的编码-解码结构,在编码器将输入编码成上下文向量C后,在

解码时每一个输出Y都会不加区分地使用这个C进行解码,这样并不能有效地聚焦到输入目

标上。

Seq2Seq引入Attention模型后,Attention模型(注意力模型)通过描述解码中某一时

间步的状态值和所有编码中状态值的关联程度(即权重),计算出对当前输出更友好的上下

文向量,从而对输入信息进行有选择性的学习。

1. 关于Attention模型,下列说法正确的是:

A 只编码出一种上下文向量

B 对各个输出值使用同一个上下文向量

C 对输入信息进行无差别学习

D 描述当前输出和所有输入元素的关联程度,计算出针对当前输出的上下文向量

2. 关于Seq2Seq+Attention模型,下列说法正确的是:

A 与只使用Seq2Seq模型没有区别

B Seq2Seq引入Attention模型后,可以计算出针对当前输出更友好的上下文向量

C 没有Seq2Seq的效果好

D 以上说法均不正确

1=>D 2=>B