目录

目录Python全系列 教程

3567个小节阅读:5930.1k

目录

鸿蒙应用开发

C语言快速入门

JAVA全系列 教程

面向对象的程序设计语言

Python全系列 教程

Python3.x版本,未来主流的版本

人工智能 教程

顺势而为,AI创新未来

大厂算法 教程

算法,程序员自我提升必经之路

C++ 教程

一门通用计算机编程语言

微服务 教程

目前业界流行的框架组合

web前端全系列 教程

通向WEB技术世界的钥匙

大数据全系列 教程

站在云端操控万千数据

AIGC全能工具班

A A

White Night

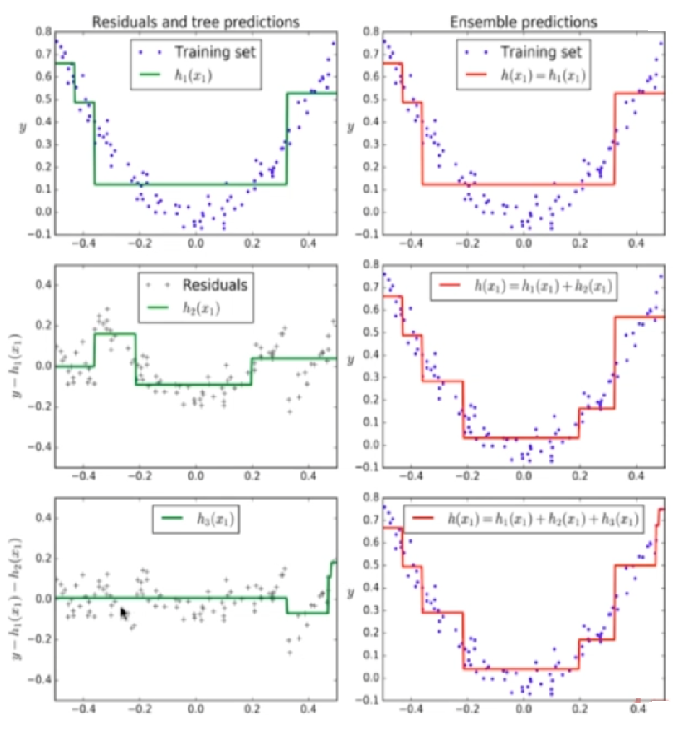

和Adaboost不同,Gradient Boosting 在迭代的时候选择损失函数在其梯度方向下降

的方向不停地改进模型。

注意:

Adaboost和Gradient Boosting的区别主要在于从不同的角度实现对上一轮训练错误的数据更多关注,Adaboost主要对数据引入权重,训练后调整学习错误的数据的权重,从而使得下一轮学习中给予学习错误的数据更多的关注。

1. 关于Gradient Boosting算法,下列说法正确的是:

A Gradient Boosting集成的多个模型是互相独立的

B Gradient Boosting 选择损失函数在其梯度方向下降的方向不停地改进模型

C 最终的预测结果是通过使用最后一个模型的预测结果

D 以上说法均不正确

2. 关于Adaboost与Gradient Boosting,下列说法正确的是:

A Adaboost与Gradient Boosting集成的多个模型都是互相独立的

B 两者的区别主要在于从不同的角度实现对上一轮训练错误的数据更多关注

C Adaboost算法每一轮的样本权值都在减小

D 以上说法均不正确

1=>B 2=>B